|

| Autoproduction / Culture libre / Économie non-marchande / Libertés / Recherche conviviale / Critique de la science économique / Critique de l'économie marchande alternative / De tout et de rien |

| La fabrique - Blog / Textes |

| Textes sur l'économie non-marchande et la culture libre |

| Articles en tout genre... que l'on peut librement diffuser, modifier, publier, discuter et évaluer. |

Science ouverte et WEB 2.0

Auteurs: Benjamin Grassineau (voir aussi l'historique)

Création de l'article: Mars 2010

Etat de la rédaction: achevé

Droit de rédaction: ouvert sur invitation

Licence: Licence culturelle non-marchande

Création de la page: 15 octobre 2011 / Dernière modification de la page: 16 février 2026 / Créateur de la page: Benjamin Grassineau

Résumé: Les techniques et les pratiques du web 2.0 ont-elles un impact sur la science professionnelle ? Conduisent-elles à l'essor d'une science plus ouverte et horizontale ? Cet article soumet ces questions à une analyse conceptuelle, empirique et historique. Il montre notamment que le courant de la science ouverte se scinde historiquement en deux courants. L'un, auquel on peut rattacher la pensée de WIENER, a conduit à l'émergence des techniques proprement dites du logiciel libre et du web 2.0 ; l'autre, auquel peuvent être rattachés les travaux d'ILLICH, a précédé l'essor des « idéologies » propres au web 2.0. Notre étude montre par ailleurs que ces techniques ont eu pour l'instant un impact très limité sur l'ouverture et l'horizontalité de la science professionnelle. Malgré leur essor, la science ouverte s'est peu développée. Nous en concluons qu'une approche en terme de déterminisme technique est inadaptée pour expliquer l'évolution récente de la science ouverte.

Divers travaux ont aujourd'hui pour thème de recherche les relations entre le web 2.0 et la science. L'idée qui en émerge est que les « nouvelles » techniques et outils du web 2.0 induiraient, ou produiraient, une science ouverte « inédite », opposée dans ses principes et ses usages à la science professionnelle. Autrement dit, l'essor de certains outils, comme les blogs, les réseaux sociaux et les wikis serait en train de provoquer un changement des représentations et des pratiques dans la science professionnelle, et pourrait constituer dans certains cas un « danger », en conduisant à une dégradation de la qualité des contenus publiés1.

Cette position s'appuie sur certains présupposés qu'il convient d'analyser empiriquement et théoriquement. D'abord, elle suppose que soit défini avec précision le champ de ce que l'on nomme science ouverte. Ensuite, elle nécessite, pour qu'il y ait déterminisme technique, une antériorité des techniques du web 2.0 sur les pratiques et les « idéologies » de la science ouverte. Enfin, elle suppose que la disponibilité des techniques du web 2.0 ait effectivement un impact significatif sur l'ouverture et l'horizontalité de la science professionnelle. Or qu'en est-il vraiment ?

Je propose d'examiner cette question en la plaçant dans une perspective diachronique. Je présenterai pour cela un historique et une définition du concept de science ouverte, et montrerai, ce faisant, en quoi et comment certains projets et techniques du web 2.0 s'y rattachent et s'y insèrent. J'en déduirai notamment que :

- la science ouverte précède l'essor des techniques, pratiques et « idéologies » du web 2.0, puisqu'elle est issue de deux courants idéologiques qui s'interpénètrent dès les années 1960,

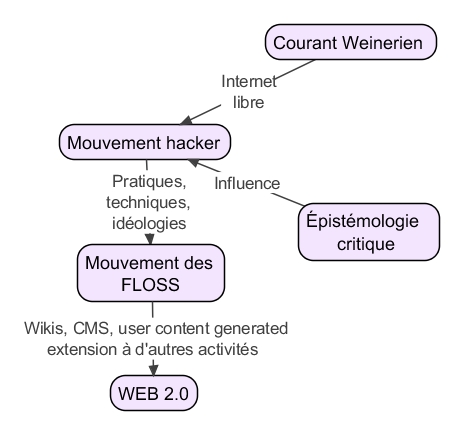

- ces courants ont contribué à produire des techniques, des pratiques et des idéologies, dont le le logiciel libre, la « philosophie du libre » et, en particulier, le web 2.0 font partie (voir schéma en annexe),

- la diffusion des techniques et surtout des pratiques du web 2.0 est faible dans la science professionnelle et influe peu sur la place occupée par la science ouverte dans le champ scientifique.

Cette dernière proposition parachèvera ma démonstration.

Les fondements historiques de la science ouverte : quelques pistes.

Les critiques de la science professionnelle et les alternatives proposées à celle-ci ont la particularité d'être hétérogènes et graduées. Il y a un fossé important, en effet, entre la défense du libre-accès aux publications – ce qu'on appelle parfois, à tort, l'open science – et l'application du principe de publication ouverte à la publication académique. Il faut donc d'abord délimiter à quoi renvoie la notion de science ouverte, à quels modèles elle se réfère et à quels projets concrets elle peut être assimilée. C'est ce que nous proposons de faire ici, en examinant - superficiellement - les fondements historiques et sociologiques de ces critiques et en voyant comment elles se projettent dans l'alternative de la science ouverte.

Remarquons tout d'abord que les critiques de la science ne sont pas neuves. Qu'on songe aux nombreuses déclinaisons du mythe de la « science incontrôlable » ou du « savant fou » qui colonisent l'imaginaire occidental dès le XIXe siècle, allant du roman de M. SHELLEY, Frankenstein ou Le Prométhée moderne (1818) à La fin d'Illa (1925) de J. MOSELLI, en passant par La Mort de la Terre (1911) de J. H. ROSNY AÎNÉ. Ne faut-il pas voir dans ces manifestations de l'imaginaire, une critique latente de la science, qui expose l'humanité à de graves dangers, et qui est impuissante face aux forces qu'elle déchaîne ?

Certes, mais c'est toutefois le « choc » des deux guerres mondiales et de la guerre froide qui cristallise et légitime ces critiques2. Car à mesure que la participation des scientifiques aux techniques de guerre est reconnue, et que les effets indésirables et les menaces des techniques modernes deviennent palpables (avec l'arme atomique, l'Organisation Scientifique du Travail, les techniques de propagande, etc.), elles apparaissent dans des « essais », puis, dès les années 1970, dans la littérature académique3, tout en se concrétisant peu à peu dans des démarches de recherche plus ouvertes, essentiellement, au départ, dans les sciences humaines et sociales et dans les sciences médicales4.

Il y a alors un accord tacite autour de l'idée que le progrès scientifique et technique peut avoir des effets négatifs, ou tout au moins ambivalents. Mais les positions diffèrent sur l'origine de ces effets et sur les « remèdes ». L'ambivalence des effets provient-elle des usages de la technique, de ses caractéristiques intrinsèques ou de son mode d'appropriation5 ? En réponse à ce questionnement, trois courants se démarquent.

Le premier s'appuie sur l'idée d'une science neutre, séparée de la technique, qui elle-même ne produit des effets négatifs qu'en fonction de ses usages. Dès lors, il ne faut pas entraver la recherche scientifique et le progrès technique (de toute façon considérés comme inévitables), mais seulement réguler les usages des techniques à posteriori – par exemple, sous la conduite des pouvoirs publics, en les orientant vers des politiques de développement.

À l'inverse, le deuxième courant suppose l'existence d'un lien puissant entre science et technique6, ou à défaut entre intérêts étatiques et marchands et intérêts scientifiques et techniques7. Par conséquent, en vertu de la thèse selon laquelle les effets du progrès technique sont imprévisibles et ambivalents8, la régulation de la technoscience doit se faire à priori : les citoyens devraient par exemple pouvoir participer aux décisions en matière de recherche9.

Deux courants en apparence opposés mais en fait unis par un même préjugé. La science ne peut être que « professionnelle », fermée. Elle est définie et pensée dans ce cadre. Ses réalisations et ses outils peuvent certes être contrôlés à priori ou à posteriori, mais l'accessibilité des outils aux non-scientifiques n'est pas envisagée. Elle n'aurait de toute façon pas d'incidence sur les sciences et les techniques, car celles-ci suivent une évolution autonome - on retrouve la position internaliste10. Et par conséquent, le mode d'appropriation de la science n'a pas d'incidence sur la science produite et sur les techniques qui en découlent. C'est cette conception d'une science pure, neutre et indépendante de son mode d'appropriation, qui est rejetée par le troisième courant qui constitue à proprement parler le courant de l'épistémologie critique.

Le courant de l'épistémologie critique

Ce courant peut être scindé en deux sous-courants : l'un se développe durant la seconde guerre mondiale, l'autre n'émerge véritablement qu'à partir des années 1960.

Le premier peut être illustré par les thèses de WIENER (1971) qui s'articulent autour de deux positions :

- la science doit être indépendante des pouvoirs et intérêts marchands et politiques (notamment militaires),

- la science doit fonder – et être fondée sur – une société où la communication est libre, c'est à dire, non entravée par les institutions.

Deux conditions nécessaires au progrès scientifique et social, et à la démocratie.

Ce courant reste toutefois minoritaire, puisqu'une large partie des scientifiques après la seconde guerre mondiale collaborent avec l'armée11. Ils sont même les initiateurs actifs de nombreux projets militaires impliqués dans le développement des armes de destruction massive12. À l'exception, précisément, d'Internet13, sur lequel l'influence des idées de WIENER se fait fortement ressentir, tant du point de vue technique, que technologique14, idéologique et pratique15. Ses idées, via le mouvement hacker dont STALLMAN fit partie16, influent notamment sur l'émergence du logiciel libre17, qui lui-même joue un rôle central dans l'émergence du web 2.018 et qui s'étend aujourd'hui à d'autres domaines d'activités, comme l'art libre, la musique libre, les semences agricoles libres, etc.

Ce sont donc ces thèses, même si elles se sont sensiblement transformées entre les années 1950 et 200019, ainsi que les outils qu'elles ont contribué à créer, qui se retrouvent - en partie bien sûr - à l'origine des mouvements pour l'open science, l'open research, l'open education et la science 2.0. Le concept d'Académie du Net de HIMANEN (2001) illustre bien cette transition entre le modèle de contribution au logiciel libre et celui de l'éthique hacker20. Et on retrouve une filiation directe entre des projets issus du logiciel libre et des projets de la science 2.021.

Ce courant conserve toutefois une dimension « scientiste » assez marquée, significative chez WIENER22. De plus, si le courant wienerien part du principe que la « valeur épistémologique » de la science et les applications techniques dépendent de son mode d'appropriation, puisqu'une science objective doit être soumise à la critique, ce qui nécessite la libre circulation de l'information, il cantonne la critique aux institutions extérieures à la science. La professionnalisation de la science n'est pas visée, ce qui l'est, c'est l'appropriation du savoir et des outils de communication par des acteurs extérieurs à la science (brevets, secrets industriels, secrets militaires, censure, etc.), qui entrave la libre circulation des informations entre les scientifiques professionnels.

C'est une différence notable avec le deuxième courant, dont on pourrait situer arbitrairement l'émergence dans les années 196023, pour lequel, au contraire, le mode d'appropriation a des effets épistémologiques, techniques et politiques. Lorsqu'il est fermé, il favorise notamment les aspects dogmatiques, hiérarchiques et « autoritaires » de la science, qui prédisposent à son instrumentalisation par les pouvoirs économiques et étatiques24. Chez FEYERABEND, le propos est clair. La science professionnelle n'est ni une force sociale critique : c'est au contraire un des plus « puissants alliés » de la société industrielle ; ni fondée sur le mode critique : elle agit comme une « police de la connaissance », filtrant, hiérarchisant et orientant les connaissances légitimes25. À une science hiérarchique, fermée et marchandisée (mode d'appropriation), correspond donc une science cloisonnée et unifiée derrière des dogmes, et d'autre part, des techniques mises au service des intérêts marchands et étatiques. Il y a système. Science professionnelle, techniques, pratiques et idéologies s'influencent et se structurent mutuellement dans un système cohérent. D'où selon FEYERABEND, la nécessité de séparer la science de l'État et de déréguler l'organisation scientifique, de manière à rétablir l'innovation scientifique et la neutralité applicative de la science, et renforcer ainsi sa puissance critique au détriment de sa puissance autoritaire26.

On retrouve ici l'idée d'une science présentant les deux visages contradictoires de l'autorité et de la critique27. L'autorité tendant aujourd'hui à prédominer, du fait que la recherche scientifique s'est industrialisée, marchandisée, massifiée et professionnalisée au cours du XXème siècle. La science libre et ouverte, celle qui émergeait de la collaboration spontanée d'amateurs dispersés, a disparu au profit d'un monopole radical de la science professionnelle sur l'activité scientifique.

De là, sans doute, la voie de la déprofessionnalisation prônée par ILLICH (2004), et qui vise au développement d'une science conviviale répondant aux besoins des citoyens, et non aux attentes des institutions et des professions. Thèse qui se retrouve chez un auteur comme ROGERS (1996, p. 187-211, 2005, p. 143-163) avec la « science non-directive »28. Car pour ces auteurs, si une science professionnelle engendre la massification culturelle, l'hétéronomie, des techniques destructrices, l'accroissement des grandes bureaucraties, une science ouverte aura précisément les effets inverses. Et il n'y a donc, ni déterminisme technique, ni « fatalisme technique », les outils, les sciences et les technologies qui sont développés n'engendrent pas mécaniquement des effets sociaux, elles sont seulement instrumentalisées par les professions qui doivent pour cela, les enserrer dans un mode d'appropriation fermé29.

En résumé, ces deux courants convergent vers un constat épistémologique commun : la science professionnelle, fonctionnant sur le mode de l'exclusion ou de la contrainte, tant en terme de « production » que de « consommation » des produits de l'activité scientifique, atténue la diversité, l'échange d'informations et le processus de critiques mutuelles, nécessaires à la progression du savoir scientifique; ce qui impacte sur sa « valeur épistémologique ». Mais ils convergent aussi vers un constat socio-politique, lié à ce constat épistémologique : les effets négatifs de la science dépendent dans une très large mesure du caractère fermé de la science, de son mode d'appropriation dominant ; à une science fermée, professionnalisée, monopolisée par les institutions marchandes ou politiques, correspond une science qui produit des effets négatifs croissants, notamment parce que les progrès technoscientifiques se dirigent alors spontanément vers les orientations impulsées par ceux qui la financent ; à l'inverse, à une science ouverte, autonome, citoyenne, correspond une régulation sociale autonome, locale, plus souple, moins destructrice, qui permet le développement de représentations, de savoirs et de pratiques plus diversifiées.

Un idéal-type de la science ouverte.

Les alternatives proposées par ces différents auteurs (recherche conviviale d'ILLICH, anarchisme épistémologique de FEYERABEND) présentent des différences importantes. Néanmoins, leur finalité est commune et s'inscrit dans un projet de changement social bien défini. Ce qui permet de dégager un idéal-type de la science ouverte, construit autour de quelques grands principes.

- Autonomie. Les recherches et les évaluations se font de façon indépendante, locale, autonome, décentralisée et grâce à des financements sans contre-partie.

- Égalité. L'activité scientifique est fondée sur des rapports horizontaux : pas de hiérarchie dans le classement des travaux, des scientifiques, des laboratoires, des universités, égalité de l'accès aux outils de production et de publication.

- Éthique. La science tient compte de ses applications potentielles, notamment grâce à la participation des profanes à la science, et les processus de recherche et action sont intégrés.

- Libre-accès. Les extrants de l'activité scientifique (savoirs et techniques) sont facilement accessibles, sans contre-partie et leur consommation n'est pas dirigée ou obligatoire.

- Libre association ou démocratie. Les groupes de recherche adoptent un mode d'organisation démocratique, ou se configurent selon un principe de libre association spontanée et volontaire. Il en va de même pour les relations entre groupes de recherche.

- Non-coercition sur la production. Les choix de recherche, de contribution, d'enseignement, d'association, de courant de pensée sont libres, volontaires et non-contraints.

- Ouverture. L'activité scientifique et les outils nécessaires à sa production, son évaluation et à sa diffusion30 sont accessibles à tous (aux profanes, aux amateurs et aux professionnels), et il n'y a pas de contrôle sur les contenus. Les amateurs, les profanes participent à égalité à ces différentes phases de l'activité scientifique.

- Pluralisme. L'activité scientifique peut être faite dans des cadres méthodologiques et théoriques distincts.

Outil convivial et réseaux du savoir

Cet idéal-type recoupe-t-il les deux courants de l'épistémologie critique ? Penchons-nous pour le montrer sur la notion d'outil convivial développée par ILLICH31. Elle a l'avantage d'être fédératrice, et de plus, la liaison historique entre la pensée d'ILLICH et le développement de techniques informatiques décentralisées est avérée32.

L'outil convivial se définit comme un outil33 que chacun peut utiliser « sans difficulté, aussi souvent ou aussi rarement qu'il le désire, à des fins qu'il détermine lui-même. L'usage que chacun en fait n'empiète pas sur la liberté d'autrui d'en faire autant. Personne n'a besoin d'avoir un diplôme pour avoir le droit de s'en servir; on peut le prendre ou non. Entre l'homme et le monde, il est conducteur de sens, traducteur d'intentionnalité »34. Il n'induit pas un « travail standardisé, dirigé hiérarchiquement (...), [mais] une constante disponibilité devant des formes d'activité de subsistance toujours neuves, simples et finies, dont la production ne peut être planifiée par les fonctionnaires, dirigée par les hiérarchies et qui répondent aux valeurs intrinsèques d'une communauté spécifique »35. L'outil convivial définit donc un rapport entre les individus et l'outil qui est celui d'un « usager-producteur » intégré dans les processus contrôlés par des communautés ouvertes. Ouverture qui peut consister à « substituer à l'habilitation par les professionnels ou l'administration une investiture par des citoyens élus; (...) protéger les libertés productives, même et surtout si elles sont extra-industrielles; garantir au profane qualifié le droit de pratiquer sans habilitation formelle »36. Transition vers une société conviviale où « travail, loisir et politique favoriseraient l'apprentissage » et qui s'appuierait sur une réforme du Droit et sur la déscolarisation37.

Pourquoi cette déscolarisation ? Car ILLICH oppose deux situations-types. L'une où le savoir est instrumentalisée à des fins marchandes et politiques. L'échange de savoir s'inscrit alors dans une relation hiérarchique, contraignante et marchande. À l'opposé, les savoirs et savoir-faire peuvent être échangés ou partagés dans une relation horizontale, non contraignante, mais au contraire facilitante, à l'intérieur de réseaux du savoir, ouverts à tous, grâce auxquels « sont agrandies les chances de chacun d'apprendre et d'enseigner », permettant à ceux qui s'intéressent à une question particulière d'entrer en rapport avec d'autres personnes qui manifestent le même intérêt. Quatre principes doivent structurer ces réseaux du savoir38 :

- Le libre accès aux produits de la publication39.

- L'ouverture des outils de publication. En permettant que « ceux qui désirent partager leur connaissance puissent rencontrer toute autre personne qui souhaite les acquérir », et ceci sans discrimination sur la personne ou le contenu enseigné40.

- La facilitation de la publication. Des intermédiaires permettent que les porteurs d'idées nouvelles qui veulent affronter l'opinion publique puissent facilement se faire entendre et tenir des réunions41.

- La séparation entre ces réseaux du savoir et les intérêts des professionnels. La production et l'échange de savoir visent des objectifs individuels, communautaires ou sociétaux.

En somme, ce que ILLICH prône, c'est une société du savoir fondée sur un mode d'appropriation ouvert des outils matériel et immatériels (outils du savoir et savoir sur les outils), qui, pour lui, sont sous le contrôle quasi-exclusif des professions. Ce qui inclut tous les outils et contenus matériels et immatériels produits ou utilisés dans le cadre de l'activité scientifique :

- Les outils de production : instruments de mesure et de traitement des données, laboratoires, locaux, observatoires, outils d'expérimentation et d'observation, salles, etc.

- Les outils de diffusion : livres, revues, salles de cours, etc.

- Les outils d'évaluation : jurys, outils de classement des revues, règles d'évaluation, etc.

- Les contenus : brevets, formules, idées, théorèmes, théories, etc.

- Les droits de diffusion, d'appropriation et de transformation du savoir.

En sachant que l'exclusion d'usage (ou l'obligation d'usage) envers ces outils peut être de différents ordres.

- Physique : lieux légitimes, outils de recherche, etc.

- Légale : diplômes, monopole légal d'enseignement, droits d'exclure et de discriminer financièrement et juridiquement.

- Symbolique : spécialisation, standardisation des publications, obligation de rentrer dans des courants, écoles, méthodes, interdiction d'aborder certains sujets d'études, monopole de certaines théories sur des champs du savoir, etc.

On voit ici que la diversité des paramètres rend graduel le niveau d'ouverture d'un mode d'appropriation. De plus, l'outil s'inscrit dans un système. À l'intérieur d'un mode d'appropriation donné, il y a une convergence des procédures de fermeture ou d'obligation. Typiquement, dans un mode d'appropriation fermé, l'exclusion physique des salles de cours, les dispositions légales visant à les assurer, produisent une « pénurie artificielle de savoir », et conduisent à des phénomènes de professionnalisation et de standardisation culturelle. Tous les éléments sont connectés et se soutiennent.

Convergences avec le courant « wienerien » et avec ses applications.

Les convergences entre le « courant illichien » et le « courant wienerien » se situent à deux niveaux : idéologique et pratique. Examinons pour le voir les idéologies et pratiques du mouvement des FLOSS, qui se sont structurées dès les années 1970, et des projets qui en découlent, notamment ceux de la wikisphère.

Pour ce qui est du mouvement des FLOSS, il converge sur plusieurs points.

- Le rôle central attribué au pluralisme idéologique, à la transparence, à la libre expression et au libre accès aux informations. C'est frappant dans les unconferences et les barcamps qui sont, dans le principe, des rassemblements d'acteurs, le plus souvent centrés autour de thèmes relatifs aux NTIC, qui prennent la forme d'ateliers-évènements participatifs non programmés, établis dans un certain désordre, et où le contenu est fourni par les participants (on est donc proche des réunions ouvertes voulues par ILLICH). Plus généralement, l'ouverture est justifiée d'un point de vue politique : un savoir libre est nécessaire au fonctionnement des démocraties42, pratique et épistémologique : la transparence de l'information est vitale pour la science et la technique. Citons par exemple les propos de LECLERCQ (1999) : « La transparence est de mise dans un monde où la validation des travaux passe (…) par un examen critique mené par les pairs. Le logiciel libre hérite (...) de cette volonté de transparence. La disponibilité du code source (…) est la conséquence naturelle de cet esprit d'ouverture ».

- La « désappropriation » de l'outil, à l'aide du Droit. Les licences libres empêchent l'appropriation exclusive des logiciels, et elles sont fondées sur le contrat mutuel. D'où l'opposition entre logiciel libre et logiciel propriétaire. Le premier étant un outil évolutif, autonomisant, ouvert, qui reste sous le contrôle des usagers43. Ce processus de libération n'est d'ailleurs pas limité aux licences libres, il évolue en fonction des transformations techniques et économiques44.

- La régulation dans les communautés virtuelles issues de ce courant est locale, et l'outil est mis au service de ces communautés. Les conflits, par exemple, sont régulés si possible au niveau local – le caractère international du réseau Internet rendant de toute façon le recours à une instance juridique officielle difficile.

- L'ouverture des communautés qui contrôlent, produisent, utilisent l'outil est garantie aux non-professionnels. Sauf dans de rares cas, ce ne sont pas les diplômes qui régulent l'entrée dans les communautés de producteurs/usagers.

- Le principe de régulation dans les projets est la libre association sur la base d'intérêts communs, et la minimisation de la structure de régulation collective45.

- Enfin, les projets laissent généralement une grande part au ludisme, aux loisirs, à l'esthétique, et à la construction spontanée d'une identité collective autour de l'outil46.

Il y a donc une correspondance entre les principes d'ILLICH et les pratiques et idéologies issues du courant wienerien, qui se fonde sur les techniques qui en sont issues (par exemple les wikis, les techniques relatives au code-source ouvert). Si bien que sur de nombreux aspects, bien des projets du web 2.0 mettent en application – sans le savoir –, les réseaux sociaux imaginés par ILLICH.

Prenons en effet le projet Wikipédia, considéré comme inclus dans le Web 2.047, et qui provient du mouvement pour les FLOSS48. Il présente de nombreuses caractéristiques d'un projet communautaire mis au service de la gestion d'un outil convivial. Pourquoi ? D'abord parce qu'il est ouvert : la plateforme collaborative est accessible à n'importe qui et les contenus sont libres. Autrement dit, il y a bien un principe de non-exclusion dans l'accès à l'outil, qui s'accompagne, comme le projet est fondé sur la non-directivité, le volontariat et le bénévolat, d'un principe de « non-obligation » à la contribution et à la consommation.

Par ailleurs, la régulation et la coordination au sein du projet sont fondées sur une coopération horizontale (il n'y a ni obligation de contribuer, ni de supérieurs qui donnent des « ordres de contribution »), sur une transparence des communications, sur un respect du pluralisme (selon le fameux principe de la neutralité de point de vue) et dans la plupart des cas, sur la démocratie directe appliquée au sein d'une communauté qui intègre usagers, amateurs, professionnels et simples visiteurs. « Tout se vote » en effet sur Wikipédia (même si le vote n'est pas un principe normatif mais pratique)49 : l'accès aux statuts, la suppression des articles, la sélection des articles de qualité, les prises de décision, etc.

De plus, les outils stratégiques (les serveurs et la marque) ne sont pas « appropriés » dans une fin marchande, et leur gestion obéit à un principe de transparence50. Il en va de même des outils logiciels (MediaWiki), des contenus culturels annexes (Wikicommons) et des outils d'observation de l'encyclopédie (statistiques notamment, qui sont produites par des usagers / amateurs). Ce fonctionnement s'apparente à celui de l'« auberge espagnole »51, chacun trouve ce qu'il amène et ce que les autres ont amené.

Enfin, le projet est fondé sur le ludisme, comme en témoignent par exemple les noms des statuts : bureaucrate, wikiclerc, wikifée, wikifourmi, wikignoll, etc., les « essais » des contributeurs et bien d'autres caractéristiques. L'observation montre d'ailleurs que l'implication des acteurs dans le processus productif dans le cadre d'une participation ouverte, responsable, non-contrainte (donc non-marchande : pas de contrainte à l'échange), communautaire, volontaire et égalitaire, étend très largement le spectre de leurs centres d'intérêts. Même des tâches apparemment « pénibles » peuvent s'avérer plaisantes (correction systématique de fautes d'orthographes, par exemple52). D'autant plus que les wikipédiens n'étant pas guidés, ils sont libres de créer leur rôle, leur fonction, leur propre représentation du projet et de la communauté, le sens et la finalité de leur action.

Sur le plan de l'activité de production, d'évaluation et de diffusion du savoir, le projet remet aussi en cause le monopole radical qu'exercent les professions du savoir sur le domaine. D'abord, parce qu'il dynamite la frontière traditionnellement établie entre professionnels, amateurs et consommateurs; et, ceci se retrouve dans plusieurs aspects du projet : technique avec le wiki, juridique avec les licences, pratique avec les principes de neutralité de point de vue et d'ouverture. À l'opposé, les techniques de prise de décision, de redistribution des ressources, de répartition des tâches, des salaires, de limitation de l'accès au statut dans le mode d'appropriation fermé sont radicalement différentes. Par exemple, dans les procédures participatives d'évaluation des articles de qualité, les décisions sont prises par des votes ouverts, accompagnés de discussions. L'évaluation ouverte même si elle a pour dessein de filtrer les articles de qualité, permet alors d'améliorer l'article lors de la procédure de contrôle. Le vote pouvant d'ailleurs être modifié après discussion.

En définitive, le projet Wikipédia entre bien en résonance avec les analyses d'ILLICH sur la convivialité de l'outil. Il n'y pas une appropriation fermée des outils, mais plutôt, leur réappropriation par les citoyens, à l'intérieur d'organisations ouvertes et locales qui en gèrent le contrôle collectif et le fonctionnement de manière transversale. L'outil est réapproprié par une action locale, participative et démocratique, à l'aide du Droit, dans une démarche très contractuelle pour être mis au service de l'usager ou de communautés locales.

Mais on ne peut saisir la portée d'un tel projet, sans tenir compte du fait qu'il est sous différents aspects, un projet de production et de diffusion de savoir scientifique. Certes, il ne vise pas à créer des résultats scientifiques, mais à les clarifier, les classer, les évaluer, les référencer, les synthétiser. Autant de procédures de légitimation, production et transmission du savoir scientifique qui appartiennent à part entière à l'activité de recherche scientifique, mais qui se déroulent ici, à l'intérieur d'un mode d'appropriation ouvert, dans un cadre d'échange déprofessionnalisé et désintermédié. Ce qui le différencie, par exemple, de l'activité de vulgarisation traditionnelle qui s'inscrit dans une démarche plus verticale et descendante.

Reste qu'il est soumis à un objectif précis : produire une encyclopédie. Il ne peut donc remplir toutes les fonctions d'un réseau du savoir, ni concurrencer véritablement le monopole radical de la science professionnelle; de plus il est limité par le principe de « non-innovation ». Mais d'autres espaces de publication remplissent ces fonctions sur Internet. Par exemple les sites de publication ouverte et les forums Internet où la rencontre entre producteurs et consommateurs de savoir, dont les statuts sont interchangeables, peut être assurée par les moteurs de recherche (elle n'est pas directement marchande).

Il faut aussi rappeler qu'il n'est qu'un projet parmi les nombreux projets de la wikisphère et les projets de publication ouverte. Citons par exemple, pour la wikisphère, des projets proches, mais différant sur des points spécifiques (neutralité de point de vue, publicité, licences, etc.) tels Citzendum ou des forks de Wikipédia (La encyclopédia libre, Wikinfo), des wikis qui se spécialisent politiquement (Anarchopedia, Copperwiki, Ekopédia, Wikibéral, Wikigreen, etc.), d'autres sur des thèmes particuliers (Hitchwiki sur l'autostop, Appropedia sur le développement durable, Scoutopedia, sur le scoutisme, BioPedia sur le vivant, etc.), ou d'autres, sur des pratiques d'échanges spécifiques, tel Wikiréponses, un service gratuit de question-réponses. Certains se spécialisent notammentt sur la transmission de savoirs-faire pratiques : Savoirtoutfaire, Steal This Wiki, SurvivalWiki, WikiHow, etc.

Tous ces projets de la wikisphère élargissent donc le principe des réseaux du savoir à des domaines variés. Et d'autres outils de système de gestion de contenu, libres ou propriétaires, peuvent remplir cet office : publipostage, blogs, logiciels de gestion de portails collaboratifs, etc55. Les projets d'échange de savoir s'appuyant sur ces logiciels en les orientant dans une démarche ouverte et collaborative, sont également très nombreux.

Il faut ajouter, enfin, le rôle joué par les nouveaux réseaux sociaux qui permettent à des acteurs d'en rencontrer d'autres, via des communautés virtuelles, ayant des centres d'intérêt similaires. La technique du partage de tags permet ainsi à des internautes d'annoncer des souhaits, des objectifs et de rencontrer des internautes qui partagent les mêmes. Le tout se faisant de manière décentralisée. Et les informations et les connexions, les relations sociales qui s'établissent entre les internautes, ne sont pas « organisées », puisque les tags sont produits par les internautes.

Techniques du web 2.0 et science ouverte.

Comment s'insèrent ces techniques, pratiques et idéologies du web 2.0 dans l'invention et l'évaluation de savoirs scientifiques, en sachant que les outils utilisés à cette fin ne se résument pas aux seuls outils de transfert et de stockage de l'information ? Le fait marquant dans cette intégration, c'est son gradualisme.

Distinguons en effet plusieurs types de projets :

- Type 1. Projets ouverts à la « consommation » des produits scientifiques : libre accès aux publications (Online-Journals.org, Open Access Initiative53), utilisation des outils du web 2.0 (comme le RSS) pour les recherches.

- Type 2. Projets orientés vers la coordination et le partage d'informations entre les chercheurs ou les institutions professionnelles, via divers outils et supports. Plusieurs sous-types sont repérables :

- L'archivage ouvert d'articles et de contenus scientifiques : arXiv, HAL, Librapport, etc.

- L'extension du principe d'ouverture et de transparence à des contenus et outils nécessaires à la production de la recherche, mais habituellement peu valorisés, tel le mouvement de l'Open Notebook Science, encore très embryonnaire, au sein duquel on peut inclure des projets comme Hypothèses, qui permet de mutualiser les carnets de recherche en sciences humaines, ou UsefulChel qui publie des notebook sous wiki.

- Mutualisation d'informations nécessaires au travail de recherche dans un cadre professionnel (dates de conférence, annuaire, etc.), tel les projets OpenResarch.org (sous licence CC BY) et OpenWetWare (biologie), tous deux orientés wiki54.

- Partage des bookmarks, utilisation de la folksonomie pour le classement et le référencement collectif des articles55.

- Type 3. Projets ouvert aux amateurs dans la production et le traitement des données (sous réserve que les outils soient matériellement distribués). C'est déjà le cas pour les projets de calcul distribué56 ou les réseaux d'échange entre scientifiques intégrant éventuellement la collecte de données réalisée par des amateurs bénévoles (Tela Botanica). On peut intégrer dans ces projets une partie de la citizen science57, c'est à dire, la science des amateurs, avec des projets tels que BeeWatchers, BioBlitz 2006, Citizen Science Central, Dynamic Pattern Research, GalaxyZoo, Maryland Science Center, NatureMapping, etc. La sphère des loisirs scientifiques étant étendue, le phénomène s'étend à des domaines variés : botanique, écologie, météorologie, paléontologie, psychologie, etc58.

- Type 4. Il faut distinguer dans les projets de la citizen science, ceux où l'intégration des amateurs est faite sous le contrôle des professionnels (l'amateur est dirigée par le professionnel pour répondre à ses finalités) de ceux où l'intégration et l'ouverture aux amateurs sont plus marquées, et concernent les processus d'invention, de production et d'évaluation de la recherche, et également plus horizontales (type 4). Les projets sont produits par les amateurs eux-mêmes ou en collaboration horizontale avec les scientifiques professionnels, et utilisent le plus souvent massivement les outils du web 2.0 (LISRA, The Open Dinosaur Project, Toad NUTS, Wikiversity, etc.59).

Plusieurs points doivent être soulignés.

D'abord, la contribution dans les projets de type 3 et 4 est massivement volontaire et non-marchande. La publication n'a pas, ou peu, de retombées professionnelles directes. À l'inverse, pour les acteurs de la science professionnelle, faire participer les amateurs à des projets qu'ils contrôlent, peut avoir un intérêt économique : ils peuvent utiliser le travail bénévole comme ressource gratuite. Nous retrouvons ici l'ambivalence des techniques et pratiques du web 2.0, surtout pour les sites de contenus générés par les utilisateurs, qui, dans certains cas, peuvent servir à faire participer bénévolement l'internaute ou l'amateur à une production dont il ne tire que peu de bénéfices – en le faisant parfois payer pour produire le bien, dans le cas de métavers comme Second Life60 .

Ensuite, ce qui différencie les projets de type 3 et 4 des autres, c'est qu'ils sont ouverts à la production. C'est le cas du projet Wikiversity61, hébergé par la fondation Wikimédia, qui consiste à produire collectivement, bénévolement et coopérativement un enseignement et une recherche sous licence libre sur des serveurs wikis. Ce projet est fondé sur un principe de maximisation de l'ouverture. Tout acteur intéressé peut intégrer un laboratoire virtuel, proposer des sujets de recherche, publier des recherches, dispenser un enseignement, accéder aux cours, les modifier, les diffuser et les télécharger62. C'est aussi le cas de projets de la citizen science. Par exemple The Open Dinosaur Project qui définit ses objectifs ainsi : « 1) do good science; 2) do this science in the most open way possible; and 3) allow anyone who is interester to participate. And by anyone, we mean anyone! We do not care about your education, geographic location age or previous background with palentology ».

Autre point, dans les projets de types 2 à 4, on observe un décloisonnement des processus de recherche qui ne se succèdent plus de manière linéaire : production (partage et mise en commun d'informations, recherche d'antériorité, écriture) -> évaluation -> publication -> consommation -> application (technique, vulgarisation, enseignement, etc.). Décloisonnement statutaire, entre les acteurs qui agissent aux différentes étapes du processus, et surtout, entre les différentes « sous-activités » scientifiques, qui s'interpénètrent, temporellement, spatialement et « logiquement ». Dans les projets d'archivage ouvert, par exemple, les textes ne sont plus figés au moment de la publication, ils peuvent être réédités à posteriori (principe des versions), modifiés suite à des commentaires, etc. D'autre part, les différentes étapes de l'échange (publication, accès, évaluation), peuvent être intégrées à l'intérieur d'un processus collaboratif ouvert. Par exemple, quand la gestion des informations relatives aux articles (classement, évaluation, recherche), se fait via des wikis et des outils ouverts, ou à l'intérieur de réseaux sociaux63. C'est le cas notamment des réseaux d'évaluation. Enfin, les phases d'application et de production peuvent fusionner. Le laboratoire de recherche-action du LISRA, par exemple, utilise les outils collaboratifs numériques pour produire des recherche-action qui impliquent des non-professionnels dans le processus productif, comme l'écriture d'articles ou la recherche elle-même. Mais l'intégration des amateurs peut aussi les amener à travailler sur des recherches conviviales au sens d'ILLICH, comme la permaculture, la sauvegarde des espèces, la consommation alternative, etc. C'est ce qu'on observe dans les projets de la citizen science.

Mode d'appropriation et déterminisme technique

On voit donc que l'intégration des techniques et pratiques du web 2.0 est graduée entre les projets de type 1 à 4. Et, résultat fondamental, cette graduation suit la ligne de partage entre science ouverte et science professionnelle.

En effet, observons tout d'abord que la quasi-totalité des revues académiques a seulement numérisé la publication, sans adopter ni les pratiques, ni les techniques participatives du web 2.0. Elles se situent au mieux, pour une faible minorité, dans les projets de type 1. J'ai ainsi examiné 166 revues académiques de sciences humaines et sociales référencées dans le classement 2008 de l'AERES allant de A+ à D64, aucune n'utilise d'outils collaboratifs du web 2.0 tels que CMS, commentaires, forums, listes de discussion, wikis, et aucune n'adopte le principe de la publication et de l'évaluation ouvertes. Les techniques et les pratiques du web 2.0 orientées vers l'ouverture et la participation horizontale, ne migrent donc pas, ou très partiellement, vers les outils de diffusion et de légitimation de la science professionnelle.

Symétriquement, d'ailleurs, la part des scientifiques professionnels qui participent aux projets de science ouverte de type 3 et 4 est extrêmement faible au regard de leur population totale. Dans le projet francophone Wikiversité, qui jouit d'une popularité relativement bonne du fait de sa connexion avec le projet Wikipédia, celle-ci est presque nulle. Ce sont plutôt des amateurs, des lycéens ou des étudiants qui alimentent le site65.

Certes, dans les projets de type 2 ou 3, on observe une ouverture de certains éléments de l'activité scientifique. Mais, outre le fait qu'il ne faut pas surestimer l'impact de ces projets, qui bénéficient pour l'instant d'une participation très modérée66, ils concernent en réalité des éléments dont la valeur stratégique au sein de la science professionnelle est faible, ou qui sont aisément mutualisables et faiblement valorisés sur le marché scientifique : référencement d'articles dans le cas des folksonomies (Delicious), opinions du chercheur pour les blogs ; ou alors, des éléments valorisés par le partage : communication d'évènements scientifiques67, partage d'articles déjà publiés pour accroître leur diffusion, ou alors prépublication d'articles de manière à s'assurer l'antériorité d'un résultat ou à officialiser la publication d'un article monnayable sur le marché scientifique professionnel, insertion dans des réseaux sociaux pour gérer la réputation ou les contacts professionnels, etc.68 Par exemple, sur le portail HAL, une analyse du type de dépôts, montre que les documents sans référence de publication (des documents de travail pour la plupart) ne constituent en janvier 2010 que 8,9% du total des documents entreposés.

Pour finir, on peut penser que les différents projets de type 3 et 4 que nous avons examinés, et qui sont conformes aux principes de la science ouverte, ont trois origines :

- L'épistémologie critique. Le laboratoire participatif du LISRA, par exemple, utilise massivement des outils (wikis, liste de discussion, CMS...) et pratiques (ouverture, transparence et horizontalité) du web 2.0 dans le cadre de la mise en lien et la coordination de recherche-action.

- Le courant wienerien Le projet Wikiversity en constitue un bon exemple. Mais des formes plus radicales existent, comme le mouvement du biohacking69.

- La citizen science. L'utilisation d'outils du web 2.0 est massive dans certains projets.

En conclusion, les techniques, pratiques et idéologies du Web 2.0 ont eu très peu d'impact sur la science professionnelle et sur la ligne de partage entre science professionnelle et science ouverte. Les cloisonnements entre les espaces de diffusion et de légitimation de l'information scientifiques perdurent malgré la diffusion des nouvelles techniques. Lorsque la science professionnelle intègre ces outils et ces pratiques, elle le fait conformément au mode d'appropriation sur lequel elle se fonde, pour accroître la diffusion des produits. Symétriquement, les acteurs de la science ouverte créent ou orientent ces outils (wikis, CMS) vers une coordination horizontale et une ouverture renforcée. Ce transfert d'outils d'un mode d'appropriation à un autre n'impacte donc pas de manière significative sur le mode d'appropriation, puisque l'usage de l'outil est réadapté, utilisé conformément à ses pratiques et idéologies dominantes. Il ne prend sens que si l'on tient compte du fait que chaque mode d'appropriation forme un fait social total70, où techniques, technologies, pratiques et idéologies forment système.

Mais on pourrait rétorquer que si l'impact du Web 2.0 sur la science professionnelle est faible, c'est qu'il faut un certain temps pour qu'une technique se diffuse. L'argument est cependant fallacieux, car les techniques permettant un partage collaboratif et ouvert sont anciennes (CVS, forums, liste de discussions, etc.). Qui plus est, le caractère novateur des techniques proprement dite du web 2.0 est très controversé71. On pourrait en dire autant des pratiques du Web 2.0. L'ouverture et l'horizontalité existaient sur Usenet et les forums Internet72.

Par conséquent, les acteurs de la science professionnelle auraient très bien pu intégrer ces techniques. Mais il n'y a visiblement pas eu la volonté. Symétriquement, l'adoption des outils conviviaux qui ont donné naissance au Web 2.0, à l'architecture Internet et les projets ouverts, dans lesquels nous pouvons inclure ceux des FLOSS, n'avait rien de nécessaire. Comme le souligne BAYART (2007), Internet aurait pu être conçu selon un mode d'appropriation fermé. Or, précisément, comme vu plus haut, les techniques et idéologies qui s'y sont développées ont favorisé le mode d'appropriation ouvert. Mais cette orientation d'Internet vers un outil convivial n'allait pas de soi. Et elle a été grandement favorisée, non pas par des contraintes techniques, mais par des contraintes juridiques ou politique, comme par exemple, le fait que l'outil soit « transfrontalier », donc, difficile à maîtriser.

De plus, lorsqu'on examine l'évolution d'Internet, on constate que le déterminisme culturel y a joué un rôle fondamental. Les idées de Wiener, puis celles d'ILLICH et de la contre-culture73, la philosophie du libre74, ont joué un rôle dans le choix et le développement des techniques Internet, dans la constitution des pratiques adoptées par les partisans du courant75 : code-source ouverts, communautés ouvertes, formats ouverts, hébergements indépendants, internet libre, logiciels de gestion de version, réseaux sans fil communautaires, etc., qui, mises bout à bout, forment un système cohérent. Comme le souligne à nouveau BAYART (2007), les pratiques, les techniques qui furent développées au sein du mouvement des FLOSS ont constamment rétroagi sur le développement d'Internet, en assurant l'ouverture de l'architecture constitutive de ce réseau. Le tout a donc dès le départ formé un système, où les idéologies (comme la philosophie du libre), les pratiques (comme le principes du consensus), les techniques juridiques (les licences libres), informatique (développées autour du code-source ouvert : logiciels de suivi de problèmes, logiciels de gestion de version, etc.) et numérique (les réseaux communautaires) et les applications (culture libre, démocratie numérique) ont évolué conjointement et se sont soutenues. Elles se sont faites au sein d'un mode d'appropriation ouvert. Ouvert, car justement issu de la science ouverte.

Conclusion

L'évolution actuelle de la science ouverte suggère d'envisager le développement d'une technique et les effets qui en découlent en tenant compte de son mode d'appropriation. Ce qui oriente les débats relatifs au progrès technique et à ses effets, non plus vers les propriétés intrinsèques des techniques, mais vers la façon dont elles sont appropriées. Par exemple, selon STALLMAN, dans un mode d'appropriation ouvert, les usagers peuvent plus aisément neutraliser certains effets indésirables des outils logiciels76. De même, dans une science ouverte, les acteurs tiennent compte des implications de leurs recherches, ou s'ils ne le font pas, d'autres acteurs peuvent s'y intégrer pour les infléchir dans une direction particulière.

Il resterait toutefois à étendre l'observation à d'autres champs d'activité pour généraliser de tels résultats. Par ailleurs, il faudrait également mieux théoriser les mécanismes par lesquels mode d'appropriation et effets des techniques sont reliés. Enfin, il resterait surtout, et c'est là l'essentiel, à tester la portée empirique du mécanisme. Dans quelle mesure est-il vrai, par exemple, que les fonctions malignes d'un logiciel peuvent être plus facilement repérées et modifiées lorsque le code-source du logiciel est ouvert ? L'idée paraît évidemment plausible, mais encore faudrait-il le prouver par un protocole expérimental adapté.

Annexe

Schéma causal

Bibliographie

- BAYART B. (2004), Open-Office.org, pourquoi pas ?. Texte en ligne : <http://www.framasoft.net/IMG/liberateur.pdf>. Consulté le 12/01/2010.

- BAYART B. (2007), Internet libre ou minitel 2.0, Rencontres Mondiales du Logiciel Libre 2007, Amiens. Vidéo en ligne : <http://2007.rmll.info//flash434.html>. Consulté le 12/01/2010.

- BENSAUDE-VINCENT B. (2003), La science contre l'opinion. Histoire d'un divorce, Paris, Seuil.

- BERNERS-LEE T. (2006), Le Monde Informatique, n°1115 S.

- BECKWITH J. (1986), « The radical science movement in the United States », Monthly Review.

- BRETON P. (1992), L'utopie de la communication, Paris, La Découverte.

- CASTELLS M. (1998), La société en réseau, Paris, Fayard.

- CASTELLS M. (2001), La galaxie Internet, Paris, Fayard.

- CAVALIER D. et SOOJUNG-KIM P. (2009), « The Growth of Citizen Science. How amateurs are contributing to research », The New York Academy of Sciences Magazine.

- CHEMLA L. (2005), « Une histoire d'Internet », in Les télécommunications entre bien public et marchandises, Charles Léopold Mayer, 2005.

- CHEMLA L. (2012), « Internet, c'est un truc de hippies », OWNI, 2012. Article en ligne : <http://owni.fr/2012/12/12/internet-cest-un-truc-de-hippies/>. Consulté le 06/05/2013.

- COHN J. (2008), « Citizen Science : Can Volunteers Do Real Research ? », BioScience, Vol. 58, n°3, p. 192-197.

- CROUZET T. (2006), Le peuple des connecteurs, Paris, Bourdin.

- ELLUL J. (1992), La technique ou l'enjeu du siècle, Paris, Economica.

- ELLUL J. (2004), Le bluff technologique, Paris, Hachette.

- FEYERABEND P. (1988), Contre la méthode. Esquisse d'une théorie anarchiste de la connaissance, Paris, Seuil.

- FEYERABEND P. (1999), Une connaissance sans fondements, Chennevières sur Marne, Dianoïa.

- FEYERABEND P. (2003), La science en tant qu'art, Paris, Albin Michel.

- FLICHY P. (2001), L'imaginaire d'Internet, Paris, La découverte.

- GALEZOT G. et LE DEUFF O. (2009), « Chercheurs 2.0 ? », Les cahiers du numériques, Vol 5, n°2, p. 15-32.

- GERVAIS J.F. (2007), WEB 2.0. Les internautes au pouvoir, Paris, Dunod.

- GLASSEY O. (2009), « L'internationalisation de la recherche face aux outils "ouverts" de la collaboration scientifique de masse », in LERESCHE P. et al. (Dir.), Recherche et enseignement supérieur face à l'internationalisation, Lausanne, Presses polytechniques et universitaires romandes, p. 65-85.

- HUXLEY A. (1939), La fin et les moyens, Paris, Plon.

- HUXLEY A. (1947), La science, la paix, la liberté, Monaco, Éditions du Rocher.

- LECLERCQ N. (1999), Logiciel libre : une volonté de transparence. Texte en ligne. <http://www.linux-france.org/article/these/memoire-leclercq/memoire_leclercq_monoblock.html>.

- LEETARU K. (2008), « Wikiversity; or education meets the free culture movement : An ethnographic investigation », First Monday, Vol. 13, n°10.

- LUTHIGER B. (2005), « Fun and Software Development », Proceedings of the First International Conference on Open Source Systems, Genève.

- MAUSS M. (2003), Sociologie et anthropologie, Paris, PUF.

- MINOL K. et al. (2007), « Portals, blogs and co.: the role of the Internet as a medium of science communication », Biotechnology Journal, Vol. 2, n°9, p. 1129-40.

- PAPATHÉODOROU A. (2000), Tous experts ! Des réseaux d'échange de savoirs techno-scientifiques, ZeligConf, rencontre européenne des contre-cultures digitales, Paris. Texte en ligne : http://www.samizdat.net/zelig.

- PETERSEN S. (2008), « Loser Generated Content : From Participation to Exploitation », First Monday, Vol. 13, n°3.

- PIERCE M. et al. (2009), « Using Web 2.0 for scientific applications and scientific communities », Concurrency and Computation: Practice & Experience, Vol. 21, N°5, p. 583-603

- PRADES J. et al. (1992), La technoscience : les fractures des discours, Paris, L'Harmattan.

- REBILLARD F. (2007), Le web 2.0 en perspective: Une analyse socio-économique de l'internet, Paris, L'Harmattan.

- ROGERS C. (1996), Liberté pour apprendre, Paris, Dunod.

- ROGERS C. (2005), Le développement de la personne, Paris, Dunod.

- SERRES A. (2001-2002), « Quelques repères sur l'émergence d'Arpanet », Terminal, n°86.

- SHOLZ T. (2008), « Market Ideology and the Myths of Web 2.0 », First Monday, vol. 13, n°3.

- STALLMAN R. (2007), « Ma vision du monde est différente », Framasoft. Texte en ligne : <http://www.framasoft.net/article4609.html>.

- THUILLIER P. (1972), Jeux et enjeux de la science. Essais d'épistémologie critique, Paris, Laffont.

- TURNER F. (2006), From Counterculture to Cyberculture. Stewart Brand, the Whole Earth Network, and the Rise of Digital Utopianism, Chicago, The University of Chicago Press.

- WALDROP M. (2008), « Science 2.0 », Scientific American, Vol. 298, n°5. p. 68-73.

- WEBER M. (1993), Histoire économique. Esquisse d'une histoire universelle de l'économie et de la société, Paris, Gallimard.

- WEIL S. (1962), L'Enracinement. Prélude à une déclaration des devoirs envers l'être humain, Paris, Gallimard.

- WIENER N. (1971), Cybernétique et société, Paris, Union générale d'édition.

Notes

1 Cf. MINOL et al., 2007 ; GALEZOT et LE DEUFF, 2009 ; GLASSEY, 2009 ; WALDROP, 2009. ⇑

2 En ce qui concerne l'influence des deux guerres mondiales sur l'essor d'une critique de la science, cf. BRETON, 1992 ; ELLUL, 2004, p. 324-327. ⇑

3 Et elles persistent dans l'imaginaire. En témoigne par exemple la nouvelle de P. K. DICK, Second Variety (1953). ⇑

4 Je pense ici aux courants de recherche dits « participatifs » : l'analyse institutionnelle, l'anti-psychiatrie, l'ethnométhodologie, l'intervention sociologique, la recherche-action, les recherches centrées sur la personne de ROGERS (2005). ⇑

5 Définit la façon dont les acteurs sociaux s'approprient les techniques et les outils nécessaires à la réalisation d'une activité : comment ils sont en mesure d'en exclure d'autres d'une partie de leurs usages et/ou de les obliger à utiliser les outils d'une manière qu'ils déterminent, ou d'utiliser les produits issus de ces outils. La notion pourrait être rapprochée de celle de forme d'appropriation définie par WEBER, 1993, p. 55. ⇑

6 HUXLEY, 1939, 1947 et WEIL, 1962 posent par exemple les jalons de cette analyse dès les années 1930 et 1940, mais leur position est alors minoritaire. ⇑

7 Cf., par exemple, THUILIER, 1972, p. 262.] dans le cadre de la technoscience[^Pour une analyse économique, historique et sociologique du concept, cf., par exemple, PRADES, 1992 ; BENSAUDE-VINCENT, 2009. ⇑

8 Sur cette idée, cf. par exemple ELLUL, 1992, p. 393-409. ⇑

9 Position soutenue par des fondations à but non lucratif. Cf. http://sciencescitoyennes.org/ et http://www.open-knowledge-society.org/. ⇑

10 Cf. sur le sujet, ELLUL, 1992. ⇑

11 Selon BRETON (1992, p. 40), Internet résulte d'une « petite minorité [qui] protesta théoriquement et pratiquement contre la soumission de la science à l'establishment militaire. Wiener, dès 1944, fait partie de cette minorité. Il développe alors l'idée que c'est la responsabilité des scientifiques comme créateurs d'évaluer les circonstances politiques et sociales qu'ils jugent les plus appropriées pour mettre ou non le résultat de leurs travaux dans les mains des dirigeants politiques ». ⇑

12 THUILLIER, 1972, p. 307-329. ⇑

13 BRETON, 1992 ; SERRES, 2001-2002, p. 31-32. ⇑

14 Au sens de discours sur la technique. Cf. ELLUL, 2004. ⇑

15 CHEMLA, 2005. ⇑

16 CASTELLS, 1998, p. 400-403. ⇑

17 DANG-NGUYEN et PÉNARD, 1999 ; PAPATHÉODOROU, 2000 ; BAYART, 2007. ⇑

18 GERVAIS, 2007, p. 4. C'est très clair dans la pratique des contenus auto-édités numériques et les réseaux sociaux. Pour les techniques, on peut songer aux outils tels que les CMS et les wikis. ⇑

19 À titre d'exemple, CROUZET (2006), reprend de nombreux éléments de cette idéologie, en les réactualisant : non-hiérarchie, localisme, auto-organisation, etc. ⇑

20 Il note : l'« apport du modèle hacker d'apprentissage est de nous rappeler tout le potentiel (...) à mettre sur le même plan les modèles académiques de développement et d'apprentissage. Nous pourrions utiliser cette idée pour créer une Académie du Net élargie au sein de laquelle les supports d'étude seraient libres d'utilisation, de critique et de développement pour tous. (...) Les membres du réseau seraient guidés par leur passions pour divers sujets et par la reconnaissance des pairs pour leurs contributions. (...) L'académie du Net suivrait le modèle hacker », (id., p. 84-86). ⇑

21 C'est le cas par exemple du projet OpenResearch, dont le créateur est membre du projet Wikiversity qui appartient à la fondation Wikimédia, ou encore du blog Open Social Cognition, qui pratique l'auto-publication, et dont les membres participent au projet Wikipédia. ⇑

22 Cf. WIENER (1971, p. 474) pour exemple. ⇑

23 Parfois surnommée radical science. Cf. BECKWITH, 1986. ⇑

24 FEYERABEND, 1999. Notons que l'instrumentalisation va aussi dans l'autre sens. ⇑

25 FEYERABEND, 2003. ⇑

26 FEYERABEND, 1988. ⇑

27 BENSAUDE-VINCENT, 2003. ⇑

28 J'introduis ici la locution qui me paraît bien résumer la pensée de l'auteur. ⇑

29 Voir ILLICH, 2005, p. 75-76. ⇑

30 Les deux derniers processus correspondant à l'évaluation ouverte et à la publication ouverte. ⇑

31 Sur cette notion, voir notamment ses ouvrages La convivialité et Le chômage créateur. ⇑

32 FLICHY, 2001, p. 203. ⇑

33 La largeur du concept fait qu'il peut désigner la science en tant qu'outil, les outils issus de la science et les outils utilisés par la science. ⇑

34 ILLICH, 2004, p. 485. ⇑

35 ILLICH, 2005, p. 118. ⇑

36 ILLICH, 2004, p. 83. ⇑

37 Ibid., p. 524. ⇑

38 Ibid., p. 333-334. ⇑

39 J'utilise le terme publication dans le sens d'une action consistant à diffuser des contenus informatifs ou culturels. ⇑

40 Ces outils ne sont pas nécessairement numériques. ILLICH (2005, p. 312) envisage l'ouverture et le partage d'outils tels que les presses, la télévision, les juke-box, etc. ⇑

41 Ibid., p. 303. ⇑

42 Les exemples ne manquent pas. BERNERS-LEE (2006, p. 17), partisan de la neutralité d'Internet, s'exclame dans un entretien : « Maintenir [l']aspect ouvert et non discriminatoire du Net est très important, pour que de nouveaux acteurs ou entreprises puissent y participer, pour servir de média ouvert aux flux d'information – ce qui est nécessaire pour soutenir la démocratie ». Le projet Freenet de réseau informatique anonyme et décentralisé, vise à permettre une liberté d'expression et d'information totale profitant de la sécurité de l'anonymat permise par le chiffrage, s'inscrit également dans cette ligne idéologique (voir http://freenetproject.org/). Et il en va de même pour de nombreux projets similaires : GNUnet, DarkNet, etc. Enfin, le discours est fréquent chez les libristes. Tel le développeur du module SPCA qui nous déclare dans un entretien non-directif, « je pense que les zones de pouvoir et les zones de profit sont (…) des zones de plus en plus opaques en terme d'information. Au cœur d'une mafia, il n'y a pas de transparence du tout ». ⇑

43 Prenons la position de STALLMAN (2007) : « Je voudrais vivre dans un monde où tous les logiciels sur nos ordinateurs (...) soient sous notre contrôle et respectent nos libertés. (...) Les logiciels libres, les logiciels qui respectent la liberté, impliquent que chaque utilisateur du programme est libre d'obtenir le code source du programme et de le modifier pour qu'il réponde à ses attentes mais aussi libre d'en distribuer ou d'en vendre des copies qu'elles soient identiques ou modifiées. (...) Cela signifie que les utilisateurs ont le contrôle. Avec les utilisateurs aux commandes du logiciel, personne n'a le pouvoir d'imposer des fonctionnalités malignes aux autres. Même si vous n'exercez pas vous même ce contrôle vous faites partie d'une communauté où d'autres le font. Si vous n'êtes pas vous-même programmeur, d'autres utilisateurs du programme le sont. Ils s'occuperont certainement de chercher et modifier les fonctionnalités malignes, comme celles qui vous espionnent ou vous imposent des contraintes, pour publier des versions plus sures. Il ne vous restera qu'à faire le choix de les utiliser, comme tous les autres utilisateurs les préféreront cela ne devrait normalement pas demander d'effort de votre part ». ⇑

44 La licence GPL, par exemple, gérée par la FSF, est régulièrement réécrite, en partie pour contrer de nouvelles stratégies d'appropriation des logiciels par les firmes de l'open source. D'autre part, le principe de désappropriation peut s'étendre à d'autres techniques ou technologies, tels les formats ouverts ou Internet. Il peut également y avoir une redéfinition conceptuelle, tel le passage du logiciel libre au logiciel libérateur effectué par BAYART (2004). ⇑

45 Voir la charte de la fondation du projet Gnome et le chapitre « Build on What we Have (or: too much structure is poison) ». Elle contient (voir point suivant) des passages intéressants sur l'ouverture, le caractère ludique et la nécessité de faciliter la participation : « GNOME is an open project. (...) The foundation should not be exclusionary or elitist. Every GNOME contributor, however small his or her contribution, must have the opportunity to participate in determining the direction and actions of the project. (…) Major components of GNOME (...) were begun by energetic individuals with the desire to create something cool. The GNOME foundation must not stifle the interest of outsiders. An ill-conceived foundation could discourage outsider participation directly, by establishing rules which limit the ability of potential contributors to make their mark, or indirectly, by engendering an alienating sense of elitism ». ⇑

46 Ce qui se repère, notamment, dans les caractéristiques non-techniques des projets : chats, discussions diverses, logos, noms, slogans, etc. Le codage, par exemple, est souvent considéré comme un art. « Code is poetry » peut-on lire sur le site officiel du projet WordPress. Cf. LUTHIGER (2005). ⇑

47 J'appuie mes propos sur une étude du projet dont la méthode et les résultats sont exposés dans ma thèse de doctorat. Cf. GRASSINEAU (2009). ⇑

48 Ibid ⇑

49 Le consensus est le principe normatif, mais dans la pratique, le recours au vote est prépondérant. ⇑

50 Ils sont gérés par la fondation Wikimédia. ⇑

51 J'emprunte cette idée à BAYART (2007). ⇑

52 Certains wikipédiens actifs peuvent le faire pendant plusieurs heures d'affilée, voire, des nuits entières. ⇑

53 Le projet fédère le mouvement du libre accès à l'information scientifique et technique. Voir : http://openaccess.inist.fr/. ⇑

54 La mutualisation peut aussi concerner des bases de données scientifiques, comme dans le projet Encyclopedia of Life, qui réunit de nombreux partenaires institutionnels de taille diverse : Biodivresity Heritage Library, The Field Museum of Natural History, Harvard University, etc. ⇑

55 Cf. GALEZOT et LE DEUFF, 2009 ; GLASSEY, 2009 ; PIERCE, 2009. ⇑

56 Voir « List of distributed computing projects », Wikipedia, The Free Encyclopedia, 7 janvier 2010 23:59, consulté le 8 Janvier 2010, http://en.wikipedia.org/w/index.php?title=List_of_distributed_computing_projects&oldid=336502362. ⇑

57 Voir le site de la Society For Amateur Scientists. ⇑

58 Cf. COHN, 2008 ; CAVALIER et SOOJUNG-KIM, 2009. ⇑

59 Voir le blog Citizen Science Projects qui répertorie de nombreux projets de ce type. ⇑

60 BAYART, 2007; PETERSEN, 2008 ; GRASSINEAU , 2009. ⇑

61 Une première enquête ethnographique sur le projet a été réalisée par LEETARU (2008). ⇑

62 Ces principes sont d'ailleurs expliqués dans une charte à l'adresse suivante : Wikiversity:Open Scientist. ⇑

63 Plusieurs exemples existent d'ores et déjà. Cf. GALEZOT et LE DEUFF, 2009. ⇑

64 J'ai pris les cinq premières revues (classement alphabétique) d'une discipline dans un niveau donné (A* à D), ainsi que les cinq premières revues pluridisciplinaires par niveau. J'ai éliminé les revues dont je ne trouvais pas le site Internet et la catégorie B'. http://www.aeres-evaluation.fr/La-liste-des-revues-scientifiques. ⇑

65 J'ai examiné la catégorie utilisateur.fr, qui regroupe les utilisateurs francophones et inscrits dans la catégorie (janvier 2010), et tenté d'identifier leur statut à partir des informations qu'ils renseignent sur leur page personnelle. Sur les 191 utilisateurs examinés, la répartition est la suivante : enseignants (collèges, lycées, BTS, essentiellement) : 10%, étudiants (doctorants inclus) : 29%, non renseignés ou non trouvés : 33%, collégiens et lycéens : 14%, professionnels et diplômés du supérieurs (10%), chercheurs professionnels et enseignants du supérieur (4%). ⇑

66 GALEZOT et LE DEUFF, 2009. ⇑

67 Par exemple, le site OpenResearch, annonce essentiellement des évènements autour du thème de la science 2.0. ⇑

68 Ajoutons que les archives ouvertes sont pour la plupart réservées aux scientifiques professionnels (il faut appartenir à un laboratoire), et les articles sont très rarement déposés sous des licences ouvertes. ⇑

69 À l'instar de projets comme DIYbio, Free Fermentology Foundation, Hackteria, OpenWetWare, SmartLab, etc., qui sont à la croisée de la citizen science et du mouvement hacker. ⇑

70 Je renvoie ici à une courte réflexion de MAUSS (2003, p. 393) sur les relations entre techniques et société. ⇑

71 SCHOLZ, 2008. Hormis peut-être la technique AJAX. ⇑

72 Voir REBILLARD, 2007. ⇑

73 Voir Chemla, 2012. ⇑

74 BAYART, 2007. ⇑

75 CASTELLS, 2001 ; FLICHY, 2003 ; TURNER, 2006. ⇑

76 Ibid. ⇑

Catégories

| Suivre... | ||

|  |  |